ITCOW牛新网 6月9日消息,开源 AI 平台 Hugging Face 今日发布轻量级机器人模型 SmolVLA,该模型拥有 4.5 亿参数,具备完整“视觉-语言-行动(VLA)”能力,并可在 MacBook Pro 等消费级设备上顺畅运行,旨在降低通用机器人智能体研发门槛,推动 AI 机器人技术的平民化普及。

减成本、降门槛,SmolVLA 瞄准高普适性部署

在当前大模型热潮席卷机器人领域的背景下,主流 VLA 模型大多闭源,训练成本高昂,严重依赖专用硬件与私有数据。而 SmolVLA 选择走向相反方向:

- 完全 开源

- 使用 公开数据集

- 可运行于 消费级笔记本电脑

- 支持低成本机器人平台(如 SO-100、SO-101、LeKiwi)

这一策略大幅降低了入门门槛,为机器人开发者和研究人员带来“即插即用”的便捷体验。

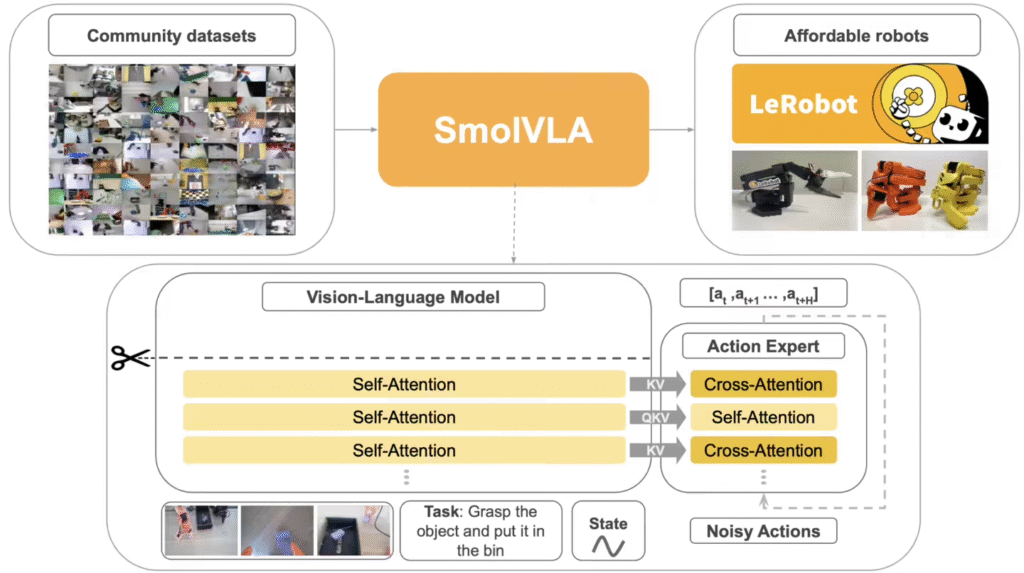

结构创新:高效整合多模态信息

SmolVLA 在架构设计上采用改良 Transformer 模型,并集成 flow-matching 解码器,结合四项关键优化:

- 跳层视觉处理:跳过视觉模型中一半层数,提升速度、减小体积

- 交叉融合注意力机制:提高多模态融合能力

- 精简视觉 Token 数量:增强处理效率

- 采用轻量视觉编码器 SmolVLM2:降低算力门槛

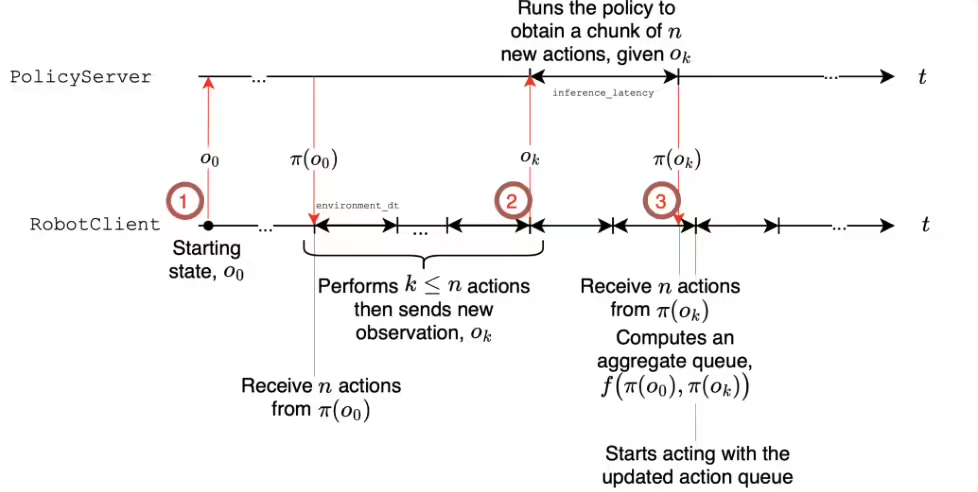

此外,其“异步推理架构”实现感知与动作执行解耦,使机器人在动态环境中响应更迅速。

表现亮眼,挑战行业标杆模型

尽管仅使用了不到 3 万条任务记录训练,SmolVLA 在多个平台展现出优异表现:

- 在模拟平台 LIBERO、Meta-World 上超越 Octo、OpenVLA 等业界知名模型

- 在真实机器人 SO-100、SO-101 的抓取、堆叠、分类任务中表现稳定,精度领先

Hugging Face 表示,SmolVLA 的泛化能力和任务适应能力已接近甚至超越部分参数更大的模型。

开放即日可用,支持 GitHub 完整复现

目前,SmolVLA 的基础模型已上线 Hugging Face 平台,完整训练代码与复现指南同步开源发布: