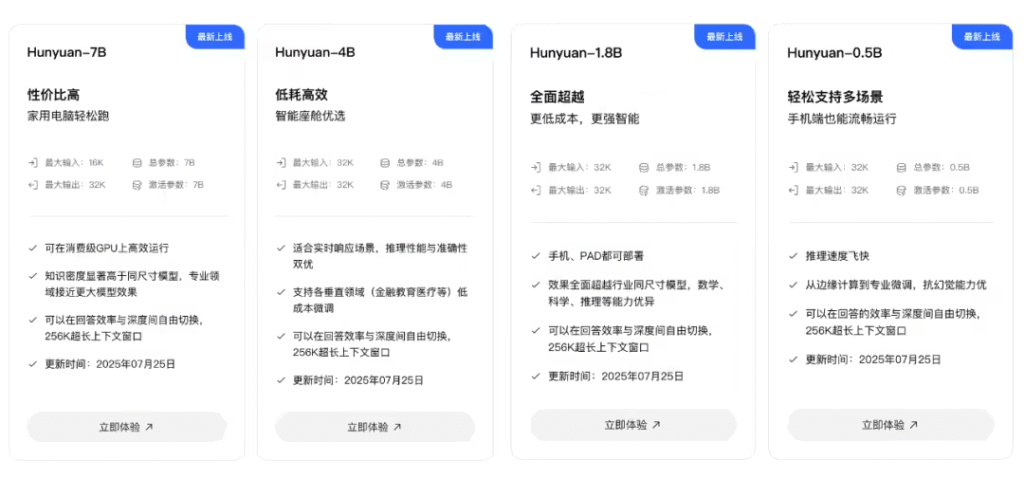

ITCOW牛新网 8月4日消息,腾讯混元大模型开源家族再添新成员。腾讯AI Lab今日宣布开源四款轻量级大语言模型,参数规模分别为0.5B、1.8B、4B和7B,专为终端设备优化设计,可在消费级显卡上流畅运行,为AI普惠化应用开辟新路径。

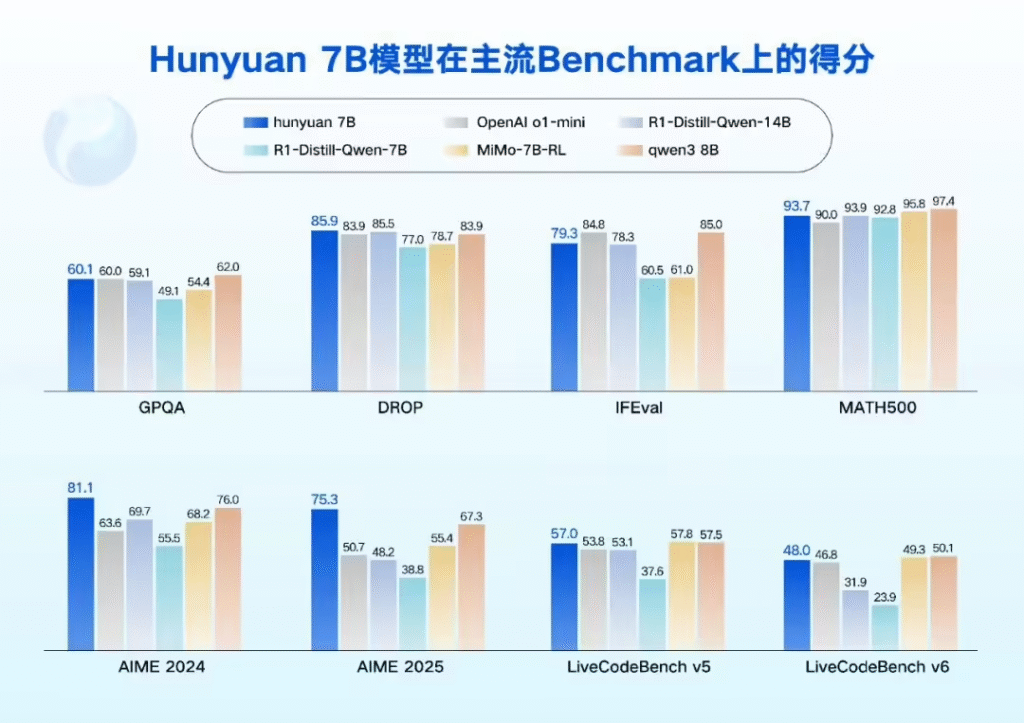

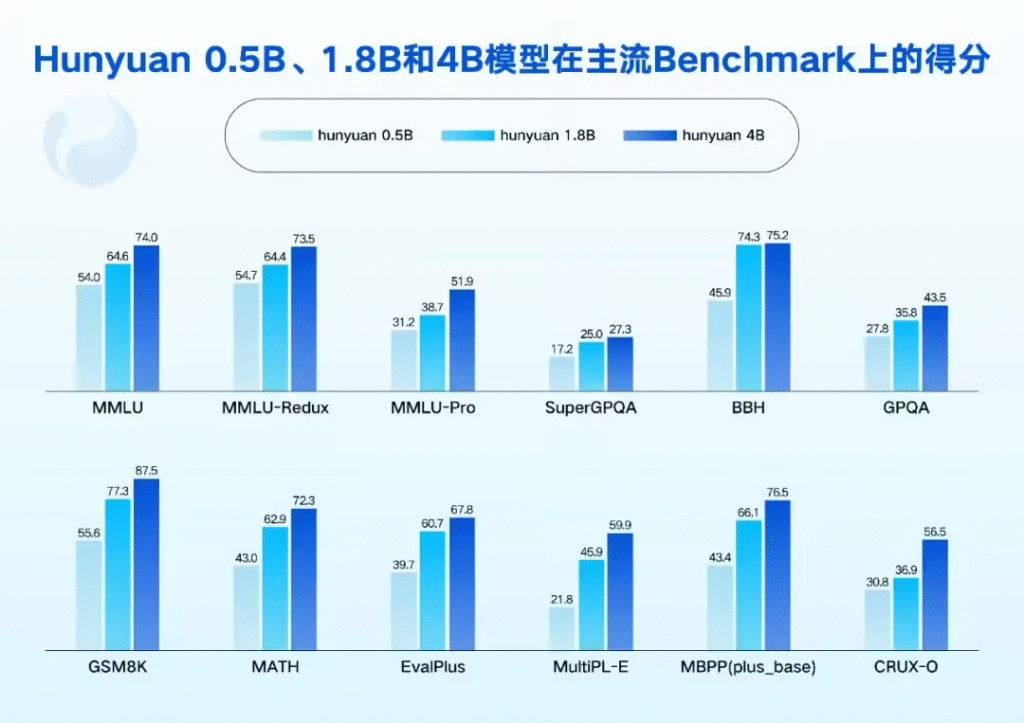

这四款开源模型采用创新的融合推理架构,用户可根据任务复杂度灵活选择”快思考”或”慢思考”模式。在性能表现上,模型在语言理解、数学推理等核心能力上达到同尺寸领先水平,特别是在Agent任务执行和长文本处理方面优势显著,原生支持256k超长上下文窗口,相当于可一次性处理40万汉字内容。

据ITCOW牛新网了解,新模型已在高通、英特尔、联发科等主流芯片平台完成适配,支持PC、手机、平板及智能座舱等多种终端部署。腾讯表示,模型开源后将大幅降低企业和开发者的AI应用门槛,推动大模型技术在垂直领域的快速落地。

技术亮点方面,这些模型通过精心设计的数据构建和强化学习机制,在任务规划、工具调用等Agent能力上表现突出。实际测试显示,模型可胜任Excel操作、旅行规划等复杂任务,展现出接近人类水平的决策能力。同时,优化的推理框架使模型在SGLang、vLLM等主流平台上都能高效运行。

在应用场景上,腾讯已将这些小模型成功部署到多个业务线。腾讯会议AI助手利用其长文本能力实现完整会议内容理解;微信读书AI可一次性分析整本书籍;智能座舱采用双模型架构平衡性能与功耗;金融AI助手通过微调达到95%以上的意图识别准确率,满足行业严苛要求。

行业专家指出,轻量化大模型的开源将加速AI技术向边缘端渗透。相比动辄数百亿参数的基础模型,这些小尺寸模型在保持核心能力的同时,大幅降低了部署门槛和计算成本,特别适合智能家居、车载系统等资源受限场景。

值得关注的是,这是腾讯混元系列继开源52B大模型和混合推理MoE模型后,再次向社区贡献重要成果。配合此前开源的文生图、视频生成等多模态能力,腾讯已构建起从基础研究到应用落地的完整开源生态。