ITCOW牛新网 12月2日消息,在昨日于加利福尼亚州圣地亚哥举行的NeurIPS人工智能大会上,英伟达正式推出业界首款面向自动驾驶领域的开源视觉语言动作模型Alpamayo-R1。该模型基于其早期Cosmos-Reason推理模型构建,具备多模态感知与逻辑推演能力,旨在为L4级自动驾驶提供核心技术支持。

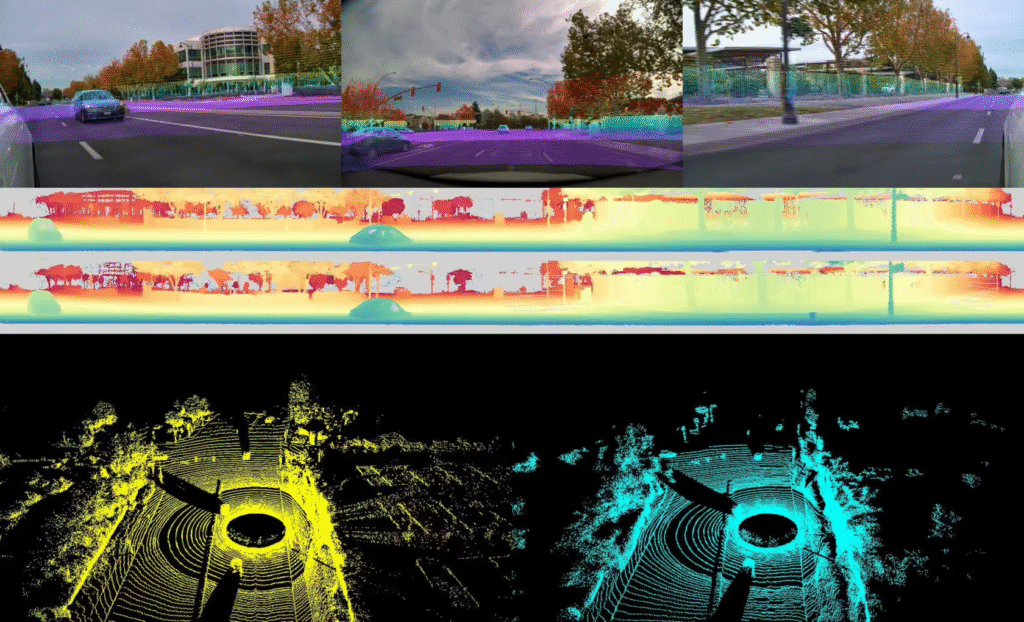

据ITCOW牛新网了解,Alpamayo-R1能够同步处理图像与文本信息,使自动驾驶系统实现环境感知与决策制定的深度融合。其推理机制允许车辆在行动前进行逻辑推演,从而应对复杂交通场景中的细微判断需求。英伟达强调,该技术将赋予机器“常识性”决策能力,例如在无明确交规约束的场景中做出合理判断。

同步发布的“Cosmos Cookbook”开发者资源包提供全流程工具链,涵盖数据整理、合成数据生成及模型评估等关键环节。目前模型已在GitHub和Hugging Face平台开源,助力开发者快速构建自动驾驶解决方案。

此次发布是英伟达布局“具身智能”战略的关键落子。公司CEO黄仁勋此前多次表示,具身智能将是AI技术下一波浪潮,而首席科学家比尔・达利则明确要将英伟达技术打造为“所有机器人的大脑”。分析认为,Alpamayo-R1的推出将加速L4级自动驾驶技术突破,其开源策略有望降低行业研发门槛,推动自动驾驶技术生态协同发展。