ITCOW牛新网 12月26日消息,小红书与复旦大学共同研发的布局控制生成模型InstanceAssemble正式开源。该技术通过创新的“实例组装注意力”机制,实现了从简单到复杂布局的精准图像生成,解决了传统方法中布局对齐不准、语义脱节等问题。目前,相关研究成果已被NeurIPS 2025会议收录。

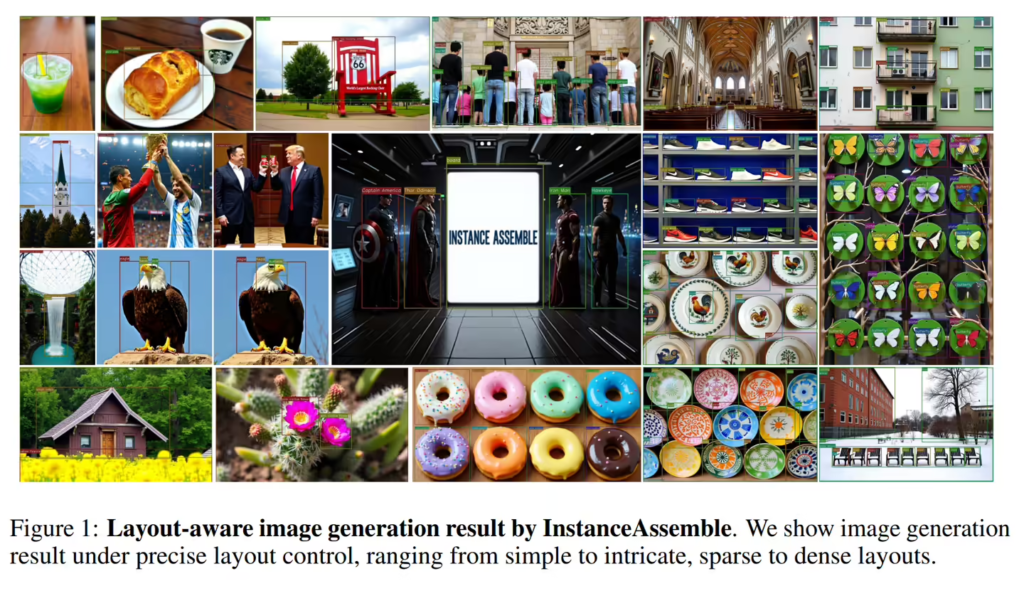

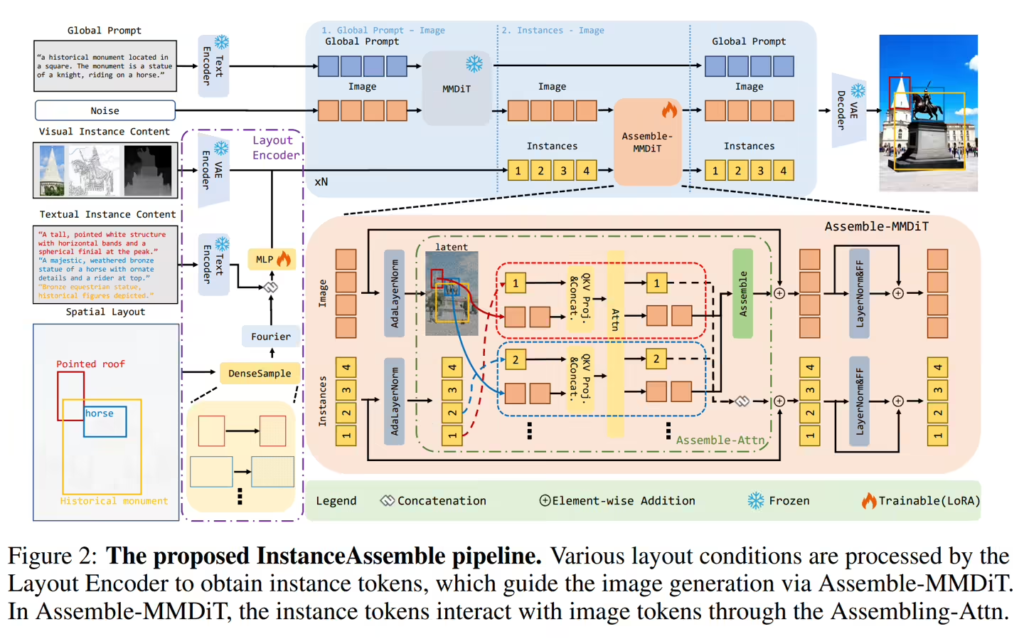

InstanceAssemble基于扩散变换器架构,用户仅需提供物体的边界框位置和内容描述,即可在指定区域生成符合语义的图像内容。无论是稀疏的少数物体还是密集的复杂场景,该技术均能保持高精度的布局对齐与语义一致性。实验显示,其在包含90万个实例的密集布局数据集上表现显著优于现有方法。

据ITCOW牛新网了解,该技术采用轻量级适配方案,仅需少量额外参数即可适配主流模型。例如,适配Stable Diffusion3-Medium仅需约7100万个参数(占比3.46%),而适配Flux.1模型时参数占比低至0.84%,大幅降低了应用门槛。研究团队还创建了包含5000张图像和9万个实例的“Denselayout”基准测试集,并提出了新的评估指标“Layout Grounding Score”(LGS),以更科学地衡量布局与图像的匹配程度。

目前,InstanceAssemble的代码与预训练模型已在GitHub平台开源,为设计、广告及内容创作等领域提供了高效工具。其开源地址已随官方公告同步发布,供开发者与研究社区直接使用。