ITCOW牛新网 1月27日消息,月之暗面今日推出并开源新一代多模态大模型Kimi K2.5。该模型采用原生多模态架构设计,同步支持视觉与文本输入,可灵活切换思考与非思考模式,兼顾对话交互与Agent任务执行。目前Kimi智能助手已全线升级至K2.5版本,官网聊天界面默认模型已完成自动切换。

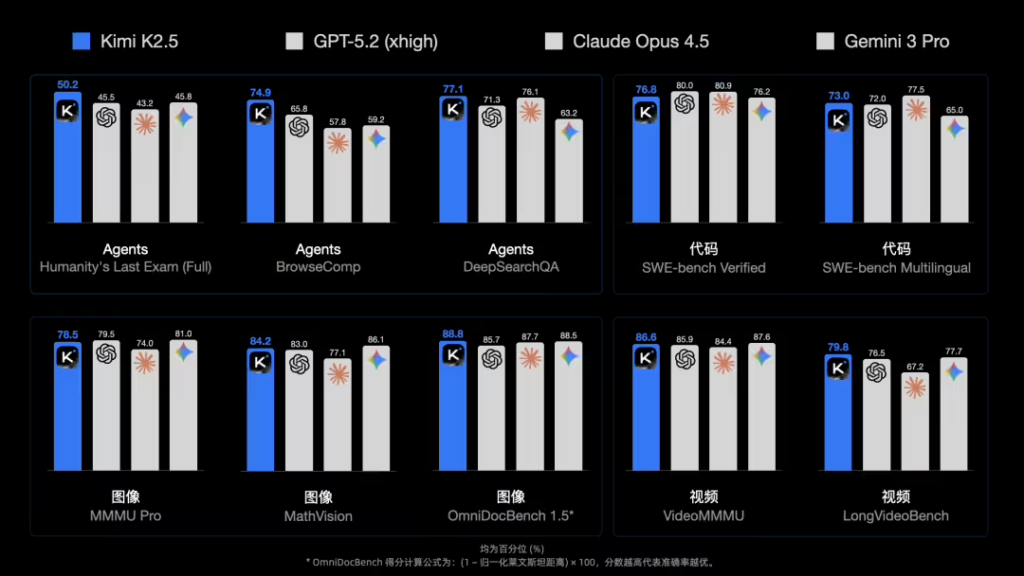

月之暗面将Kimi K2.5定位为通用型多模态模型,其在Agent任务执行、代码生成、图像视频理解及通用智能任务方面均达到开源领域的先进水平。与前期版本相比,该模型显著强化了视觉推理能力,用户现可直接上传图片、截图或录屏内容,由模型进行分析处理。这一能力特别适用于界面操作指导、文档结构解析及交互流程还原等应用场景。

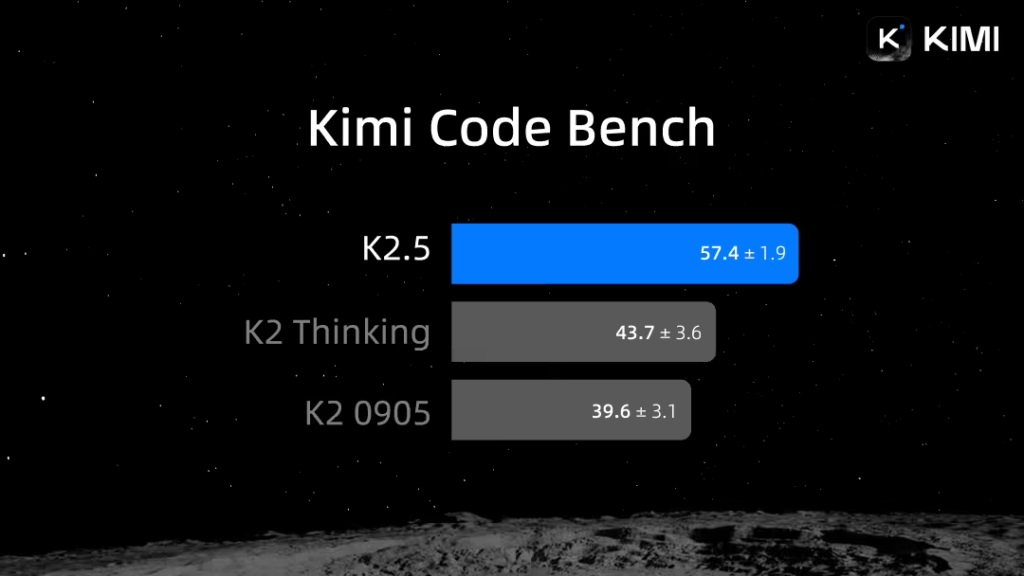

据ITCOW牛新网了解,Kimi K2.5在编程支持方面延续了K2系列的技术路线,尤其在前端开发领域表现突出。模型可根据自然语言指令生成完整的前端页面代码,处理动态布局、滚动触发等交互逻辑,并能基于界面录屏分析生成对应实现代码。此次同步推出了开发者工具Kimi Code,支持在命令行环境运行,并可集成VS Code、Cursor、JetBrains系列IDE及Zed等主流编辑器。

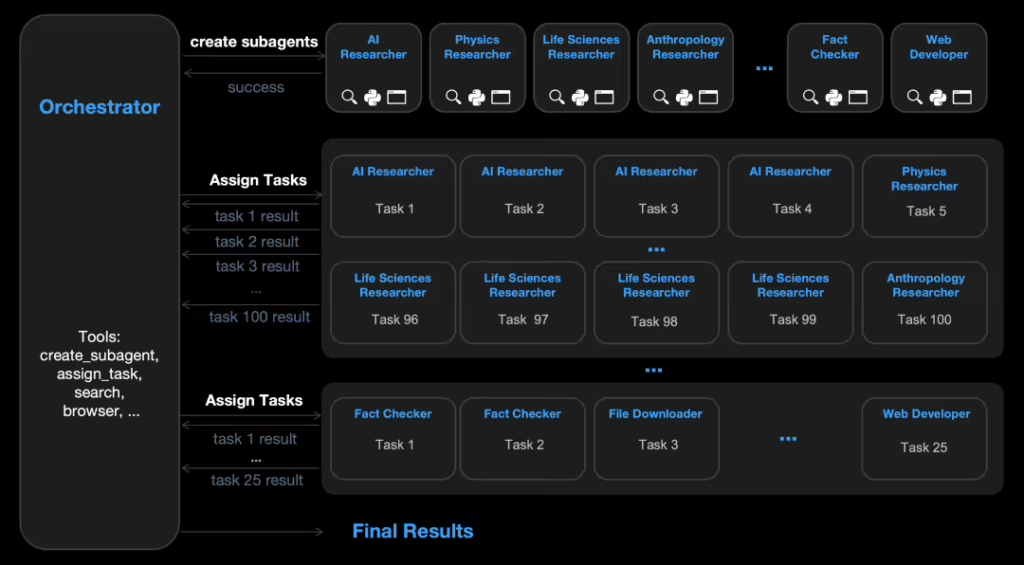

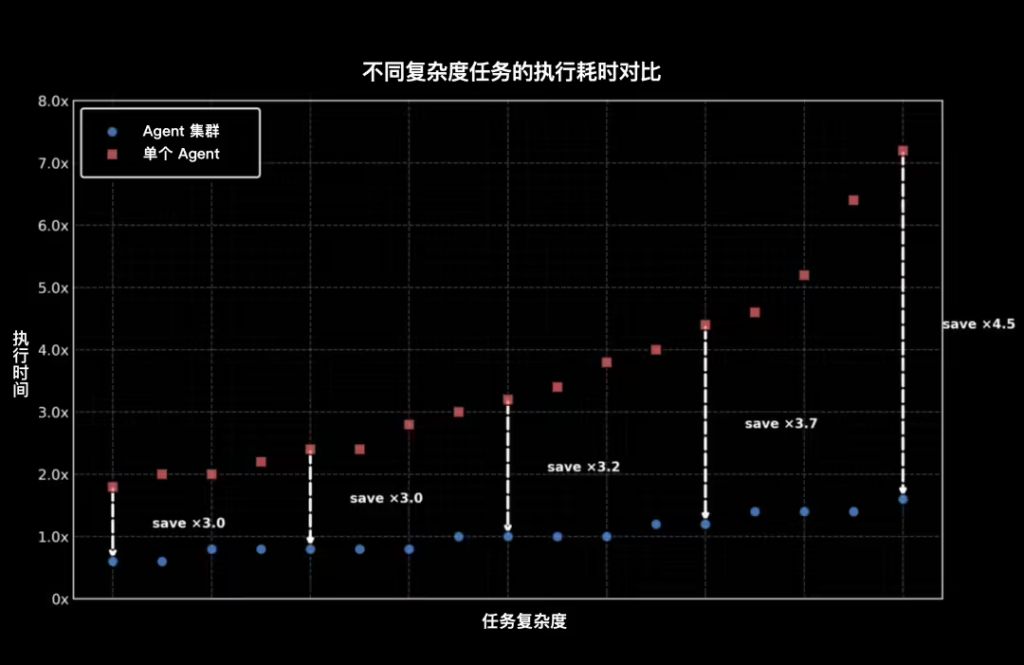

值得关注的是,K2.5引入了创新的Agent集群机制。面对复杂任务时,模型可动态生成多个子Agent并行处理不同子任务,最多支持调度上百个子Agent执行上千步工作流程。该机制在长文本处理与资料整合任务中已实现应用,可完成多篇论文的分工阅读、撰写与汇总输出。目前Agent集群功能仍处于Beta测试阶段,将逐步向用户开放。

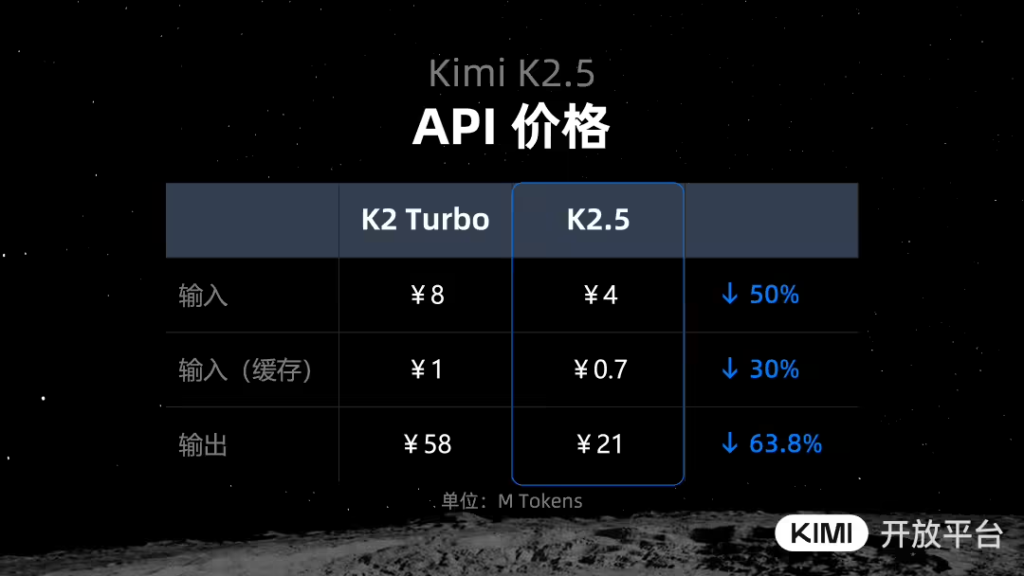

Kimi K2.5模型已在官方网站、移动App及API开放平台同步上线,普通用户可通过不同模式使用其功能,开发者和企业用户也可通过API进行调用。