ITCOW牛新网12月9日消息,据彭博社等媒体报道,谷歌发言人在采访中公开承认了此前发布的 Gemini AI 演示视频并非实时录制。谷歌指出这一演示旨在展示其大型语言模型 Gemini 的多模态能力和未来潜力。

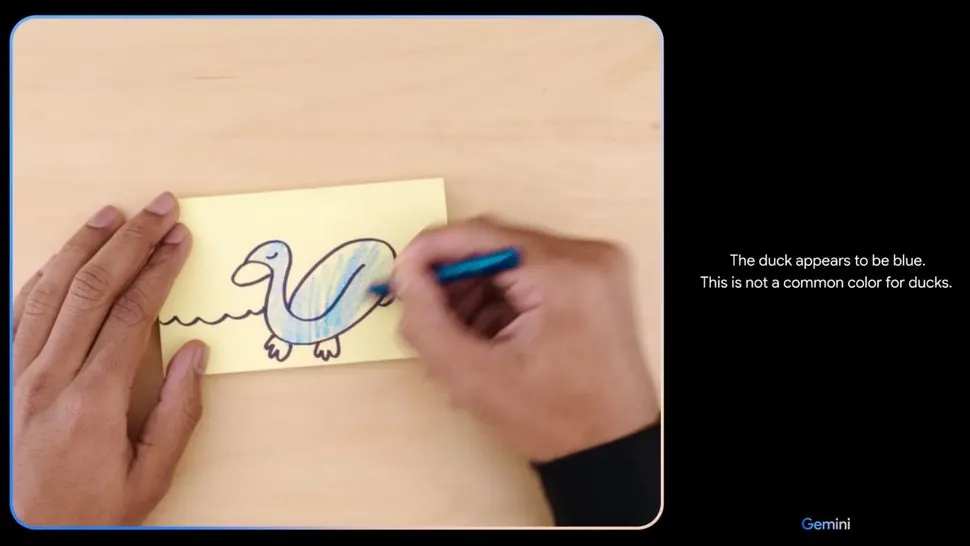

谷歌的视频展示了一名用户与 Gemini AI 的互动,看似是实时视频和音频。然而,谷歌在视频中已经声明,某些序列被缩短。事实上,视频中的语音互动并非 Gemini 实时产生,而是基于文本提示后期合成的,视频也只是使用了静态画面。

该演示视频给人一种 Gemini 能力超乎寻常的印象,然而谷歌在一篇幕后博文中展示了如何制作这段视频。谷歌发言人承认这段演示视频是利用镜头中的静止图像帧和文字提示“拼凑”而成的,例如,视频中展示了 Gemini 识别“石头、剪刀、布”手势,并在后续提示中识别出用户游戏模式中的模式。谷歌在视频说明中描述称 “为了演示的目的,延迟已经减少,Gemini 的输出也缩短了,以求简洁”。

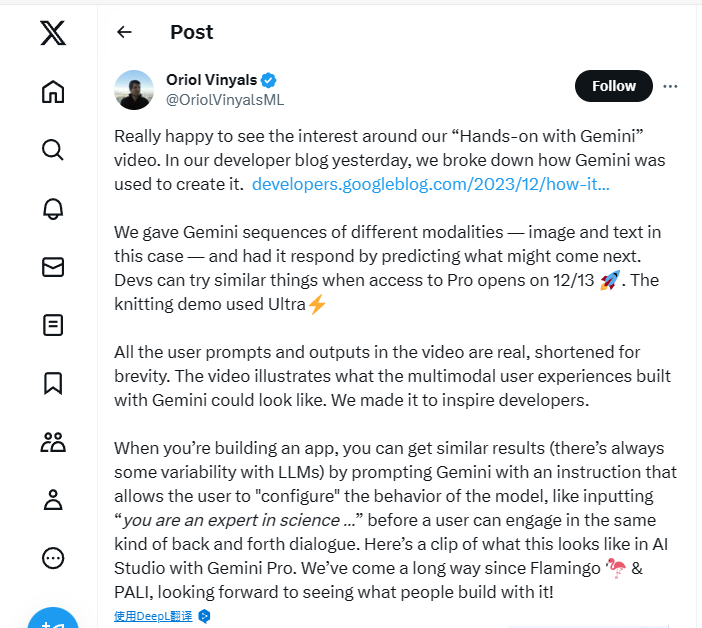

谷歌 DeepMind 的研究领导 Oriol Vinyals 解释称,这段视频旨在“激发开发者”对使用 Gemini 构建的多模态用户体验的想象。他指出,视频中所有的用户提示和输出都是基于实际的 Gemini 模型响应,但为了简洁起见进行了编辑和缩短。

此外,谷歌目前已经在使用 Gemini Pro 来驱动 Bard,并在 Pixel 8 Pro 上提供本地体验,使用的是 Gemini Nano。更强大的 Gemini Ultra 预计将于明年发布。

随着谷歌计划推出全新升级的 Bard Advanced,用户有望更好地体验到 Gemini Ultra 的先进模型和功能,这将进一步推动 AI 技术的发展和应用。